Auto-GPTは、OpenAIのGPTモデルを活用した自動化ツールです。この記事では、Auto-GPTのセットアップ方法について詳しく説明します。

必要な環境

Auto-GPTを実行するためには3つの方法があります。具体的には以下のとおりです:

- Dockerを利用する(公式の推奨)

- ローカル環境(自身のパソコンのWindowsやMac)にインストールする

- VSCode+devcontainer(VSCodeの拡張)を利用する

それぞれのメリットとデメリットは以下のとおりです。

| インストール方法 | メリット | デメリット |

|---|---|---|

| Dockerを利用する(公式推奨) | – 環境がコンテナ内に隔離されているため、他のプロジェクトに影響を与えない – バージョン管理が容易 | – Docker自体のインストールが必要 – コンテナのダウンロードに時間がかかる – パフォーマンスが多少(コンテナの実行分)落ちる |

| ローカル環境にインストールする | – 特別なツールを必要としない – 環境の設定や管理が直感的 | – プロジェクト間での環境の競合が起こる可能性がある – バージョン管理が難しい |

| VSCode + devcontainerを利用する | – VSCode内で作業を完結できる – Dockerの利点を享受しつつ、VSCodeの便利な機能を活用できる | – VSCodeとdevcontainerの知識が必要 – DockerとVSCodeがインストールされている環境が必要 |

VSCodeなどのエディタに使い慣れていている方の場合は3つめの方法がいいでしょうが、それ以外の方は1番目か2番目の方法をおすすめします。今回は1番目のDockerを利用してインストールを行いたいと思います。なお、Dockerのインストールはこちらから行っておいてください。本記事ではDocker DesktopをMacにインストールして行っていますが、基本的にどの環境でも動作します。

APIキーの取得

OpenAIのAPIキーを取得します。APIキーというのは、ChatGPTの機能を使うためのパスワード情報だと考えてください。この情報は厳重に管理して外部に漏らさないようにしましょう。APIキーはこちらから取得できます。

Auto-GPTのインストール

Dockerを使用したセットアップ

DockerとDocker composeがインストールされていることを確認します。

% docker -v

Docker version 20.10.17, build 100c701

% docker compose version

Docker Compose version v2.10.2Auto-GPTのプロジェクトディレクトリを作成します。

mkdir Auto-GPT

cd Auto-GPTプロジェクトディレクトリ内にdocker-compose.ymlという名前のファイルを作成し、以下の内容を記述します。

version: "3.9"

services:

auto-gpt:

image: significantgravitas/auto-gpt

env_file:

- .env

profiles: ["exclude-from-up"]

volumes:

- ./auto_gpt_workspace:/app/auto_gpt_workspace

- ./data:/app/data

## allow auto-gpt to write logs to disk

- ./logs:/app/logs

## uncomment following lines if you want to make use of these files

## you must have them existing in the same folder as this docker-compose.yml

#- type: bind

# source: ./azure.yaml

# target: /app/azure.yaml

#- type: bind

# source: ./ai_settings.yaml

# target: /app/ai_settings.yamldocker-compose.ymlとは、今回実行したいAuto-GPTの環境設定を定義した設計書のようなものと理解してください。例えばこのファイルを複数用意して設定ファイルやログの定義を変更することでAuto-GPTを同時に2つ以上実行したり柔軟な運用も可能です。

.env という設定ファイルがAuto-GPT自体の設定ファイルです。以下のコマンドで.envファイルの雛形がローカル環境にコピーされます。

curl https://raw.githubusercontent.com/Significant-Gravitas/Auto-GPT/master/.env.template > .envその後、テキストエディタで.envファイルを開きます。

ファイルの先頭行付近のOPENAI_API_KEY=という行を探します。

=の後に、引用符やスペースなしでユニークなOpenAI APIキーを入力します。以下のような形となります。

OPENAI_API_KEY=sk-XXXXxxxxxXXXXXX....続いてDocker Hubからイメージファイルを取得します。イメージファイルというのは今回のAuto-GPTを実行するために必要なもの(プログラミング言語の実行環境やライブラリ)をすべてひとまとめにしたものです。2ギガほどのデータサイズなので環境によっては時間がかかるかもしれません。

docker pull significantgravitas/auto-gpt動作のために最低限必要な設定は以上です。ここまで問題なければ以下のコマンドでAuto-GPTが起動します。

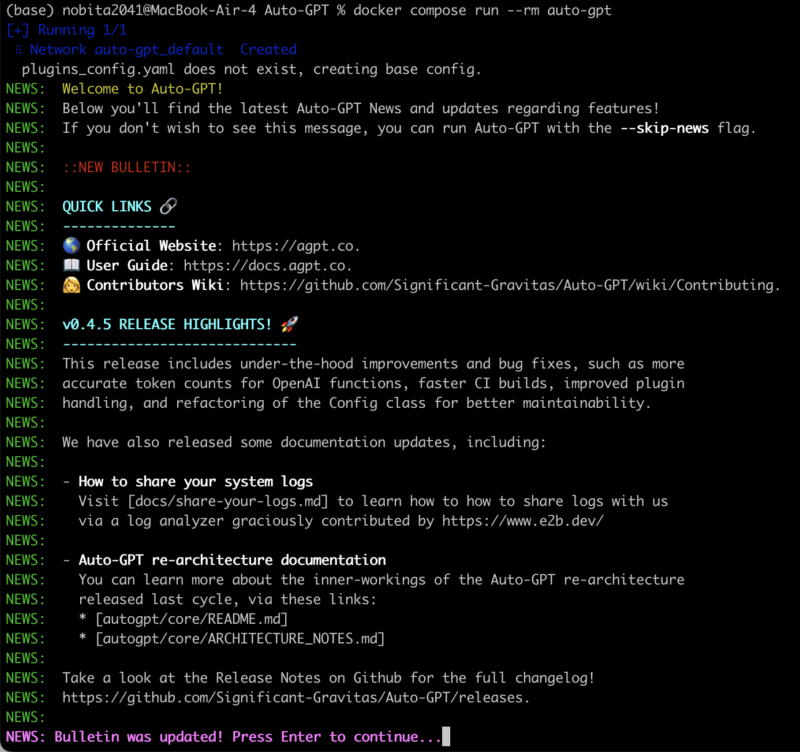

docker compose run --rm auto-gpt起動直後は以下のような画面となります。

注意

以上がAuto-GPTのセットアップ方法になります。